扫码观看演示视频

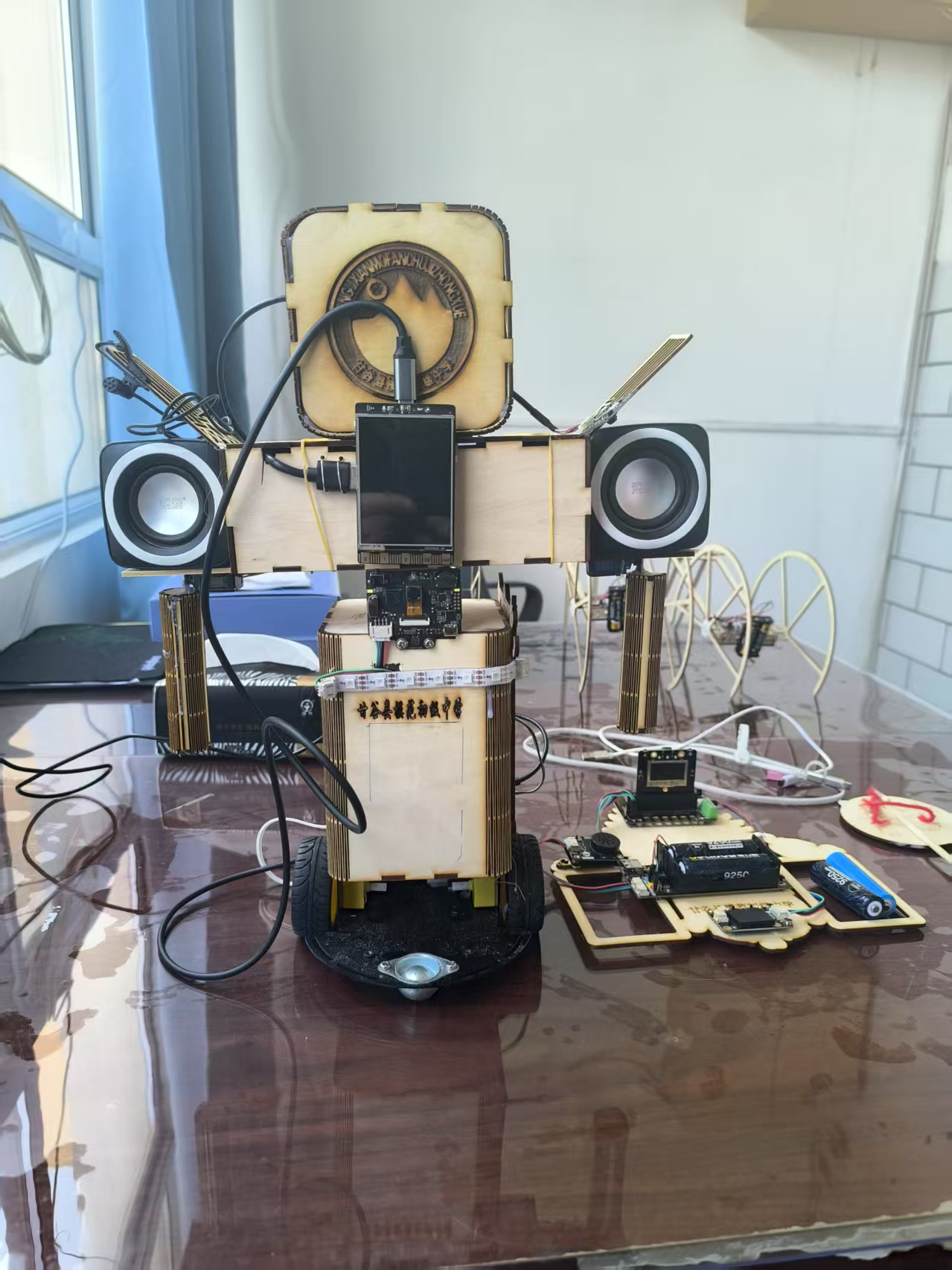

主要功能----生活辅助AI智能陪伴

1. 实时天气信息展示

• 使用 Python 的 requests 库访问中国气象局公共天气 API。

• 解析返回的 JSON 格式数据。

• 利用 ttk 库将解析后的天气信息(如温度、天气状况等)显示在行空板的本地屏幕上。

2. 热点新闻聚合

• 通过 Python 爬虫程序实时抓取微博、抖音等主流社交平台的热搜榜单。

• 对抓取到的热点新闻条目进行整合处理。

• 将聚合后的实时新闻信息反馈/展示给用户。

3. 历史上的今天(情感互动)

• 集成调用 Github 社区相关的开源历史数据项目。

• 获取“历史上的今天”事件数据集。

• 从数据集中随机选取一条历史事件。

• 将选中的历史事件信息呈现给用户,旨在提供趣味性和情感价值。

AI 交互

1. 语音交互问答(长按 B 键)

• 触发: 用户长按设备 B 键。

• 录音: 开始录制用户语音。

• 识别: 松开 B 键后,立即将录音文件发送至讯飞语音识别服务(利用其每日免费额度)进行语音转文字(STT)。

• 理解与生成: 将识别得到的文本输入传递给 Kimi 生成式语言大模型,获取模型的自然语言响应。

• 语音反馈: 使用离线 tts3 库将 Kimi 返回的文本响应转换为音频文件。

• 播放: 播放生成的音频文件,实现完整的人机语音对话交互。

2. 视觉环境分析(短按 B 键)

• 用户短按设备 B 键。

• 通过 OpenCV 库调用板载摄像头捕获当前环境图像。

• 将捕获的图像转换为 Base64 编码格式。

• 将编码后的图像数据发送给 Kimi 视觉大模型进行识别与分析。

• 将 Kimi 视觉模型返回的环境描述或分析结果文本。

• 使用与功能四相同的离线 tts3 技术,将文本结果转换为语音并播放,协助用户了解周围环境状况。

机器人控制

1. 双板协同遥控

• 利用 soit 网络通信技术,在两个行空板开发板之间建立稳定的数据连接。

• 实现指令的实时传输,达到通过一个开发板远程控制另一个开发板(例如,驱动小车移动)的效果。

2. 语音控制指令(关键词识别)

• 系统持续侦听或接收用户的语音输入。

• 通过语音识别技术,检测并解析语音流中特定的控制指令语段(如“前进”、“左转”、“停止”等)。

• 根据识别到的有效指令,生成对应的控制信号,实现对小车运动的语音控制。

3. 视觉标签追踪与跟随

• 利用二哈 AI 摄像头识别并持续追踪特定的视觉标签。

• 基于摄像头捕捉的标签图像信息,估算标签相对于摄像头的空间位置。

• 根据计算出的标签空间位置,生成控制指令。

• 控制搭载摄像头的小车进行旋转和移动,使其自动调整位姿,实现对目标标签的动态跟踪和跟随。

返回首页

返回首页

回到顶部

回到顶部

评论