闯关关卡

基础岛 | |||

|---|---|---|---|

| 关卡编号 | 关卡名称 | 关卡资料 | |

| 第1关 | L1G1000 | 书生大模型全链路开源体系 | 任务 https://github.com/InternLM/Tutorial/blob/camp4/docs/L1/ToolChain 视频 |

任务

观看「本关卡视频」和「官网」、「[GitHub(https://github.com/internLM/)」 写一篇关于书生大模型全链路开源开放体系的笔记发布到知乎、CSDN等任一社交媒体,将作业链接提交到以下问卷,助教老师批改后将获得 100 算力点奖励!!!

提交地址:https://aicarrier.feishu.cn/share/base/form/shrcnUqshYPt7MdtYRTRpkiOFJd

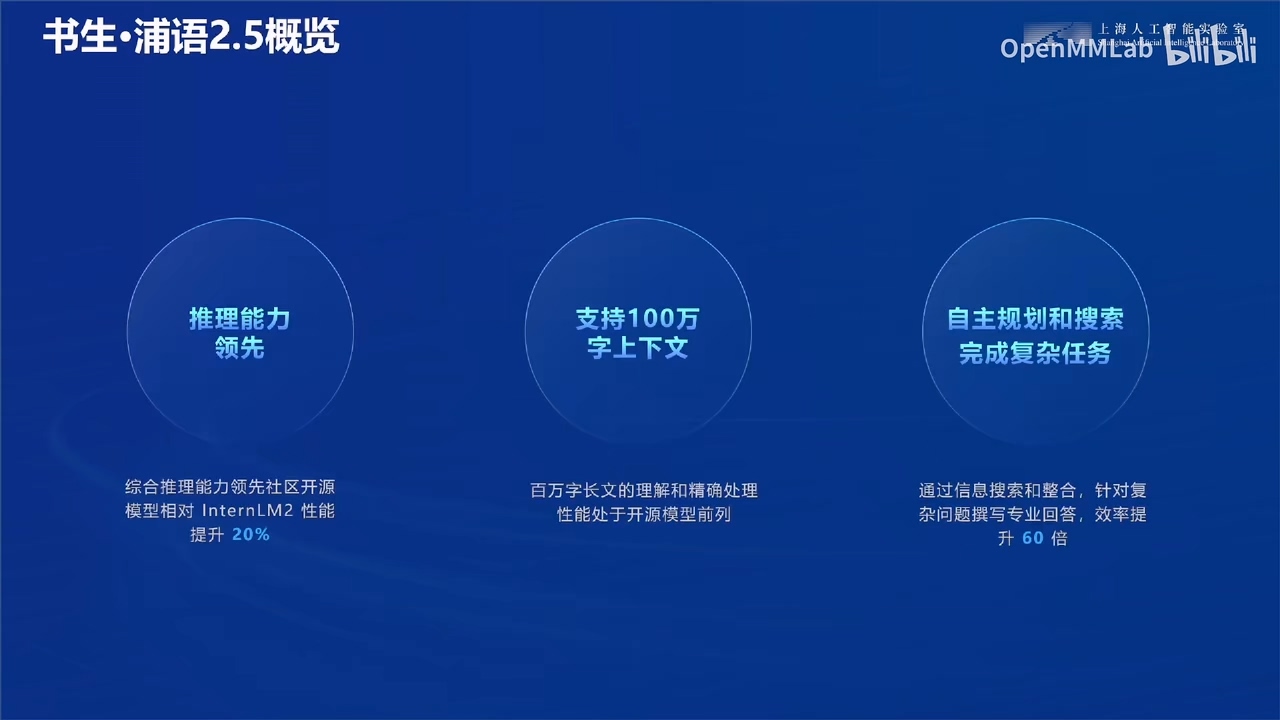

一、概述

1、概念

书生大模型,即InternLM系列模型,是由书生团队开发的一系列人工智能语言模型。这些模型以其大规模参数和强大的功能而著称,涵盖了从基础的语言理解到复杂的数学解题和图文创作等多个领域。

2、发展历程

2023年:6月7日:发布浦语系列首个千亿参数模型。7月6日:InternLM-7B模型开源,并且提供免费商用,同时发布了全链条开源工具体系。9月20日:InternLM-20B模型开源,开源工具链进行了全线升级。9月27日:开源了书生·浦语灵笔(InternLM-XComposer),这是首个支持图文混合创作的大模型。

2024年:1月17日:开源了性能超越同量级最新开源模型的InternLM2。1月23日:发布了InternLM2-Math,这是首个同时支持形式化数学语言及解题过程评价的开源模型。1月29日:发布了书生·浦语灵笔2(InternLM-XComposer2),支持个性化高质量图文创作和对话。5月24日:开源了InternLM2-Math-Plus,刷新了开源数学模型的性能上限。6月4日:开源了InternLM2-WQX,一个200亿参数量的模型,在2024年高考中取得了接近GPT-4o的成绩。

3、技术路线

(1) 广泛使用模型参与自身迭代

书生大模型通过在各种应用场景中广泛使用,收集反馈和数据,以此参与模型的自我迭代和优化。

(2) 预训练数据

模型使用大量的预训练数据来建立基础的语言理解和生成能力,这些数据为模型提供了丰富的知识和信息。

(3) 对齐数据

确保训练数据与模型的预期应用场景相匹配,通过对齐数据来提升模型在特定任务上的表现。

数据过滤&智能评估:在模型训练过程中,对收集到的数据进行筛选和清洗,确保只有高质量的数据被用于模型训练,从而提高模型的性能和准确性。通过智能评估系统来评估模型的性能,包括准确度、效率和适应性等,确保模型能够满足不同的应用需求。

模型指令生成&辅助标注:书生大模型能够根据评估结果生成相应的指令,指导模型的训练和优化过程。利用模型的能力辅助人工标注,提高数据标注的效率和质量,进一步优化模型的训练数据。

书生大模型采用持续迭代的方法,不断更新和优化模型,以适应不断变化的应用需求和技术进步。模型能力飞轮形成正向循环,即随着模型能力的提高,可以吸引更多的使用和数据,进一步推动模型能力的提升。这些核心技术思路体现了书生大模型在设计和开发过程中的迭代、数据驱动和智能化的特点,旨在通过不断的自我优化和学习,提高模型的性能和适应性,以满足各种复杂的应用场景。

4、特点

(1) 大规模参数:书生大模型拥有高达千亿参数的规模,这使得它们在处理复杂任务时更加精准和高效。

(2) 开源免费:所有模型和工具链均开源,允许用户自由使用和修改,促进了技术的共享和创新。

(3) 多样化功能:从基础的语言处理到高级的数学解题和图文创作,书生大模型覆盖了广泛的应用场景。

(4) 持续更新:书生团队持续对模型进行更新和优化,确保技术始终处于行业前沿。

5、应用场景

(1) 语言理解与生成:适用于聊天机器人、内容生成、自动摘要等。

(2) 数学问题解决:适用于教育软件、在线解题平台等。

(3) 图文创作:适用于广告设计、社交媒体内容创作等。

二、内容

1、全链条和社区生态

书生大模型的开源工具体系为用户提供了从模型训练到部署的全链条支持,有:模型训练框架、数据处理工具、模型评估工具、模型部署方案。

2、数据

全链条开源开放体系提供了丰富多样的开放数据资源,包括图像、视频、3D模型和语料库等不同类型的数据。具体数据量包括60亿图像、8亿视频片段、1万亿tokens的语料、1百万3D模型和2万小时音频。数据类型多样,覆盖了30多种不同的数据模态,如LAION-5B、SA-1B、ImageNet、MovieNet、KineticsMOT等。提供了包括The Pile、C4、WikiQA、OmniObject3D、ShapeNet、Scannet在内的多种数据集。数据总大小达到180TB,显示出该体系拥有庞大的数据资源。

提供了包括灵活检索、高速下载、智能标注和高效采集在内的多种服务和工具。

这样的体系支持10多种搜索条件的组合,以及30多种工具的组合形式,以提高使用效率。在性能指标上,服务支持的下载速度至少为20M/s,整体效率可提升40%,显示出该体系在性能上的优化。视频和音频资源包括LibriSpeech、VoxCeleb、SpeechCommands等,以及1080P高清视频和倍速播放功能。

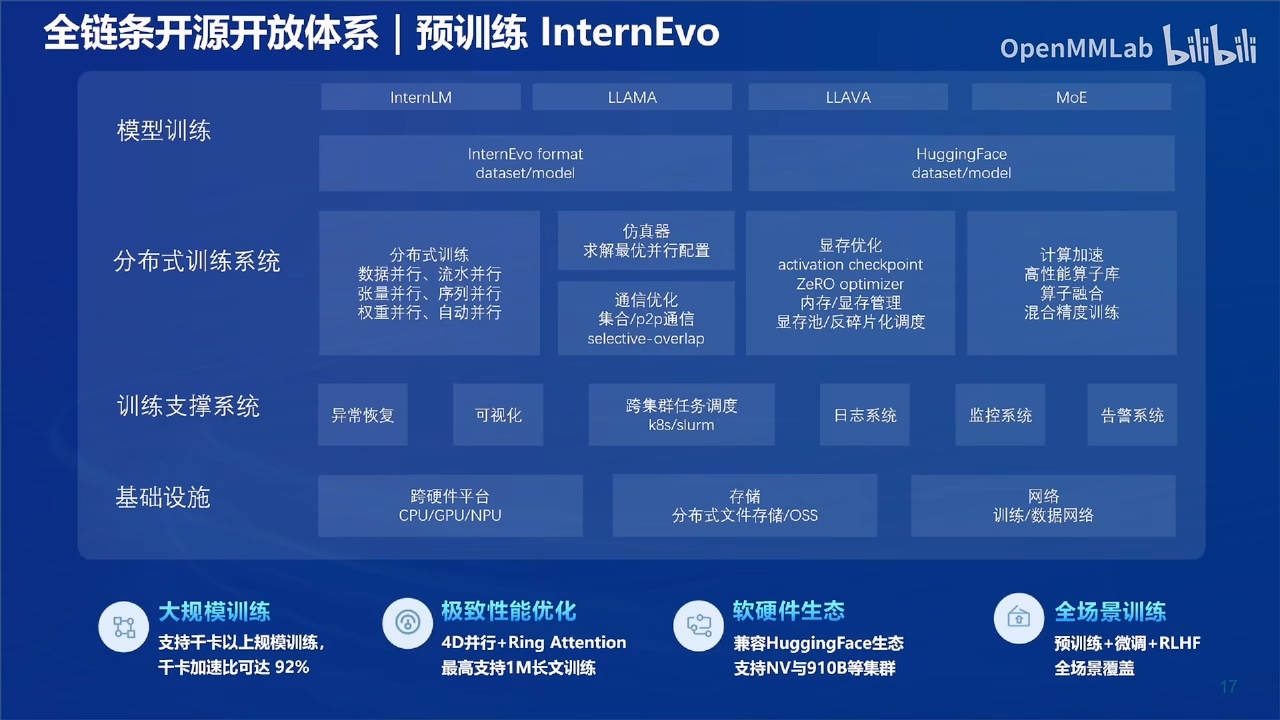

3、预训练InternEvo

全链条开源开放体详细概览,特别聚焦于预训练模型的演化(InterEvo)和模型训练的各个方面。通过分层次、模块化的划分,使得各部分功能更加明确,使得能够更好的提供多种的需求实现。

模型训练包括InternLM、LLAMA、LLAVA和MoE等模型,以及它们在训练和演化过程中使用的InternEvo format。HuggingFace平台作为模型和数据集的来源。训练技术包括仿真器用于求解最优并行配置、显存优化、分布式训练系统等。

通过数据并行、流水并行、activation checkpoint、ZeRO optimizer等技术,以及张量并行、序列并行、通信优化等方法,实现高效的训练目标。

在训练支持系统层次,包括跨集群任务调度、异常恢复、可视化、日志系统、监控系统和告警系统等。基础设施作为底层基础,涵盖了跨硬件平台、存储、网络、CPU/GPU/NPU等。大规模训练、极致性能优化、软硬件生态、全场景训练,这四个特点也形成这样预训练的主要支柱。

三、项目介绍

实战营活动助力用户上手大模型开发,已有学员开发成功项目。

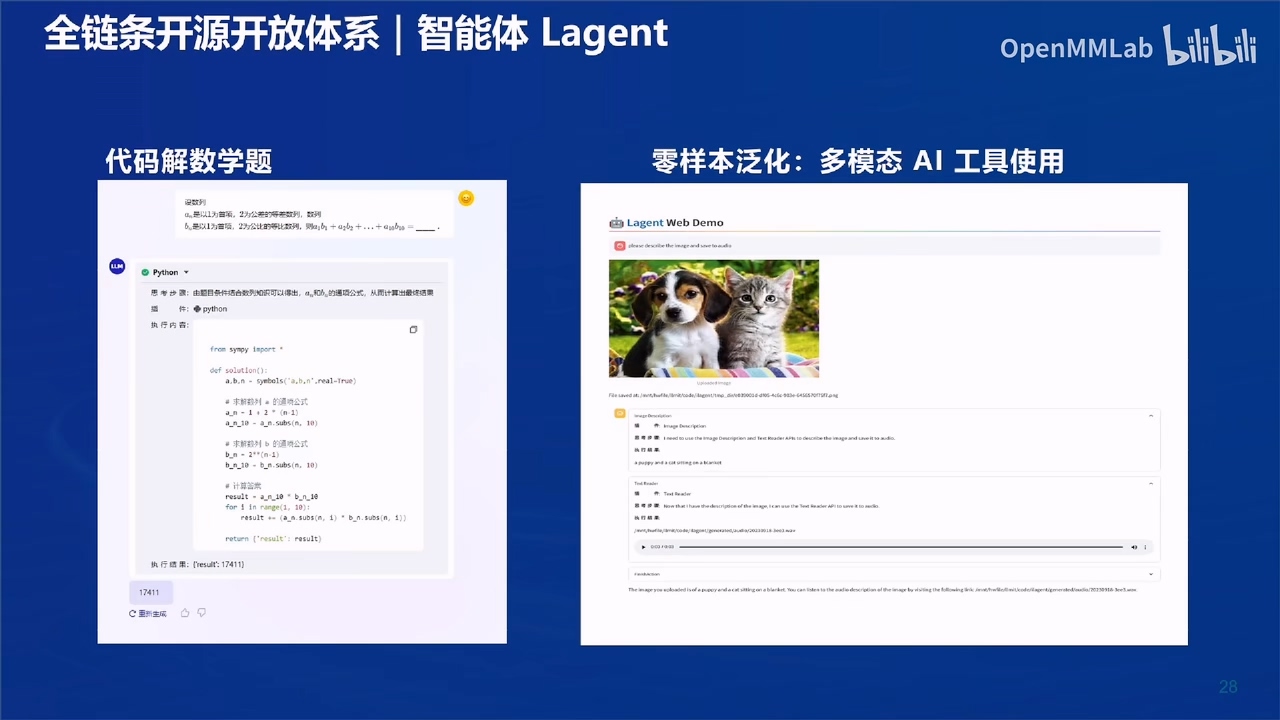

下面的是实现对数学题目的解答,输入数学问题,大模型能够对题目进行详细解答,并给出详细的执行内容。

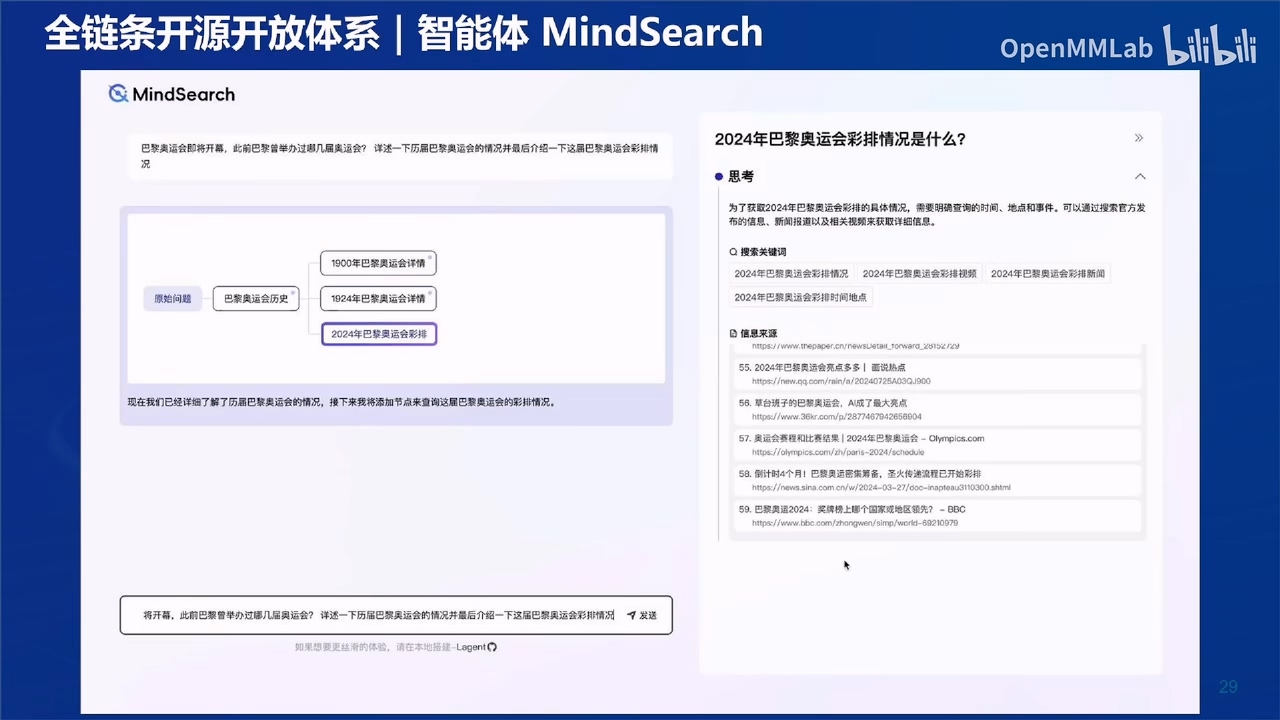

经典的问答大模型,智能体MindSearch,能够在挥发时更加的智能,更符合提问的需求,还能由此生成更进一步的内容,类如下图中的思考。同时,他还会给出相关的搜索关键词提示,给出各项回答内容的信息来源。图中可见其信息来源十分丰富、全面。

四、结语

书生大模型全链路开源开放体系为人工智能领域带来了巨大的推动力,它不仅提供了强大的技术基础,还通过开源的方式促进了全球开发者的协作与创新。随着模型和工具的不断更新,期待书生大模型在未来将发挥更加重要的作用!

返回首页

返回首页

回到顶部

回到顶部

评论